2018年11月14日

バーチャル プロダクション:デジタル ヒューマンなどについて Digital Domain に話を聞く

デジタル ヒューマンは、広がり続けるバーチャル プロダクションの可能性の一面にすぎません。ポッドキャスト シリーズ「Visual Disruptors: Exploring the Future of Virtual Production」の最新エピソードでは、Digital Domain の主要メンバーから、ゲーム エンジンやリアルタイム テクノロジーが、映像制作の分野で生産性と創造性をどのように解き放とうとしているかについて話を聞きました。

このポッドキャスト シリーズの入門編として、エピソード 1 では、バーチャル プロダクションとは何か、すでに映像分野に及ぼしている影響、そして新しいテクノロジーやテクニックの将来性などの基本情報を取り上げました。

エピソード 2「Digital Humans: Actors and Avatars」では、FX Guide の Mike Seymour 氏 (本人も研究名目でデジタル クローンされている) が、Digital Domain のビジュアライゼーション担当責任者 Scott Meadows 氏、ソフトウェア R&D 担当シニア ディレクター Doug Roble 氏に、バーチャル プロダクションとデジタル ヒューマンの分野におけるスタジオの先進的な取り組みについてインタビューしています。

最初に Meadows 氏が、『トロン』でプレビジュアライゼーション用に組み立てたオリジナル ツールセットが、その後も進化を続けていることについて説明しています。これは、グラフィックス ハードウェアとリアルタイム エンジンの両方の性能が数年前までは考えられなかった水準まで向上しているからです。『美女と野獣』、『ブラックパンサー』、『レディ・プレイヤー 1』などでツールとテクニックに磨きをかけた Meadows 氏は現在、プレビジュアライゼーションからポストビジュアライゼーション、そしてそのまま VFX ポストプロダクションまで、パイプライン全体でアセットを生かせる段階に近づいています。プレビジュアライゼーション用に作成する大まかな 3D モデルが無駄になることはもうありません。

デジタル ヒューマンを掘り下げる

ディレクターが、セットでライブ アクション要素を撮影中に CG 要素を確認できることは、根本的に自由をもたらします。高画質の CG キャラクターが俳優のインプットにリアルタイムで反応する様子を確認し、俳優ではなくキャラクターの演技を評価できるとしたら。あるいは、ディレクター自身が演技を引き受けて指示を出せたら。

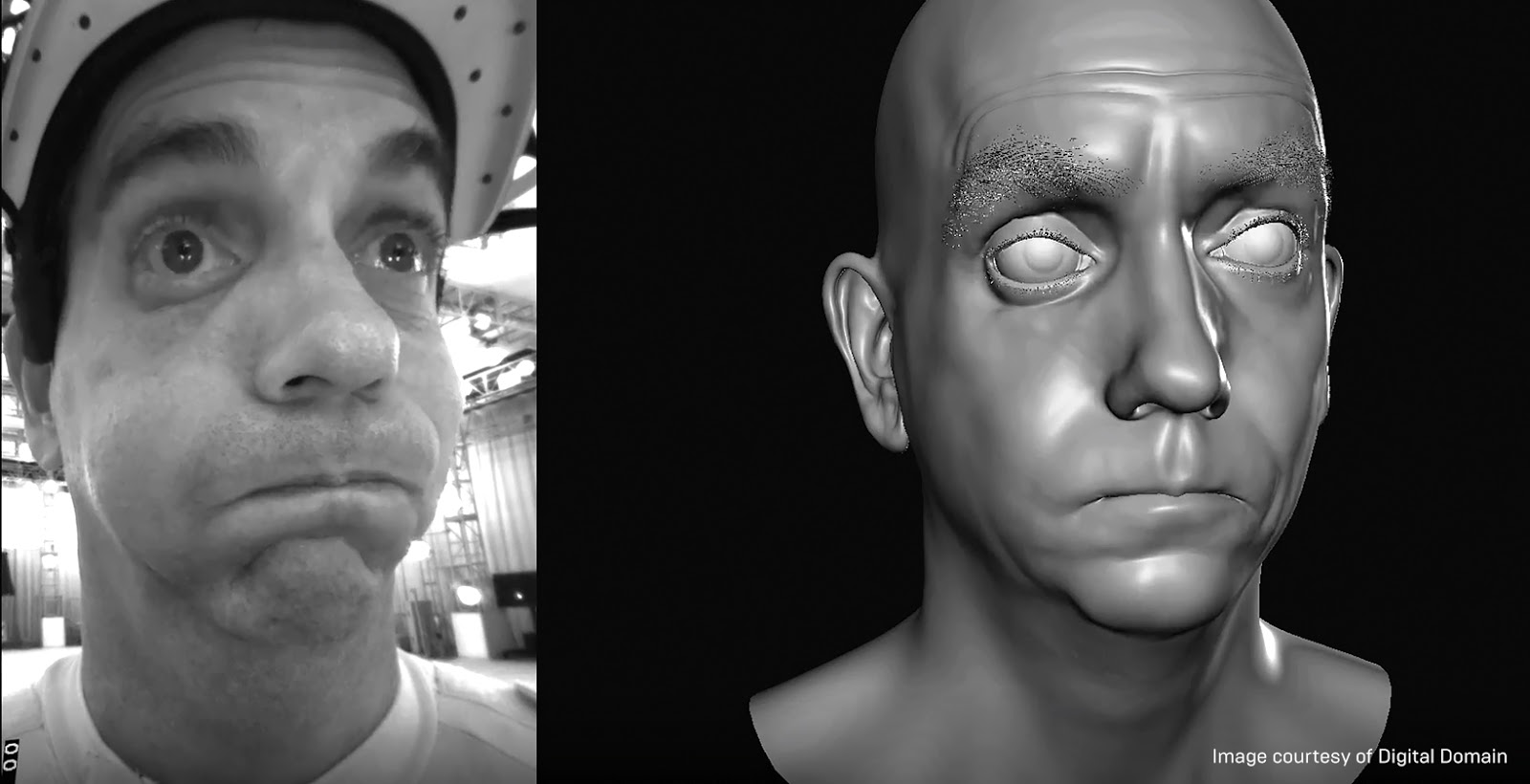

Roble 氏が「Digital Doug」プロジェクトで目指したのはまさにこの点です。Roble 氏は、自分自身を実験台に、リアルタイム、高解像度、マーカーレスで、リグを最小限に抑えたシングル カメラのフェイシャル アニメーション システムの開発に着手しました (決して小さくない挑戦です)。これを実現するために、いくつかの既存のテクニックに独自の特別スパイスを加えてから、仕上げのために機械学習に目を向けました。

最初に、USC Institute for Creative Technologies の Light Stage で、複数のポーズの超高解像度スキャンをとりました。こうしたスキャンは静止画としてはフォトリアルですが、時間的コヒーレンスがありません。つまり、1 つのポーズから別のポーズに移ろうとすると、テクスチャのスイミングが起こります。

次に、Roble 氏は Dimensional Imaging (DI4D) を使い、自分のスキャン データに時間的コヒーレンスを加えました。ただし、解像度は下がりました。

第 3 ステップは Digital Domain の通常のモーション キャプチャ段階です。Roble 氏は自分の顔に 160 個のマーカーを付け、さまざまな感情や顔の向きのフルモーション アニメーションをキャプチャしました。しかし、頂点がわずか 160 個であったため、生成されたメッシュは、フォトリアルを実現するには解像度が不十分でした。

それでもくじけることなく、Roble 氏は Digital Domain の Masquerade ソフトウェア内で機械学習を利用することに成功しました。これは、『アベンジャーズ/インフィニティ・ウォー』で初めて使用された手法です。 Light Stage と DI4D のスキャン情報を使用して、モーション キャプチャ データの解像度を頂点 80,000 個まで上げることができました。この高解像度メッシュを使用してブレンドシェイプのリグを作成し、それをアニメーターが従来の方法で操作できるようになりました。

このシステムでできることは、これだけではありません。Roble 氏は、幅広いポーズについて、非常に高解像度の画像とメッシュの組み合わせを 20,000 個作成することができました。最後のステップは、このデータを機械学習のアルゴリズムに入力し、システムのトレーニングに使用することでした。トレーニングが終了したら、システムはどのようなライブ アクションの入力に対しても、高解像度のテクスチャとメッシュの適切な組み合わせを 90 fps ものスピードで計算できるようになりました。したがって、Doug が何をしても、デジタル Doug (または Doug をベースとする別の CG キャラクター) が同じことをリアルタイムでできます。レンダリング面は Unreal Engine がしっかりと対応しています。

この画期的な新しい手法の詳細については、ここでポッドキャストをお聞きください。

仲間に加わる

ビジュアル世界の変革者の方、バーチャル プロダクションをもっと極めたいと思っている方のご参加をお待ちしております。こちらで登録されると、このシリーズに新しい投稿があったときにメールでお知らせします。

また、新しいバーチャル プロダクションのハブで、洞察に富んだ記事、ビデオ、その他のコンテンツをご覧いただくこともできます。